Riparazioni con delivery in giornata per il tuo iPhone di ogni modello. In tutta Milano

Dallo SPOOL ad iOS

- Le schede perforate ed il progetto ENIAC

- Lo SPOOL ed il primo concetto di ‘software principale’

- IBM BOS/360

- UNIX

- MS-DOS

- Mac OS e la rivoluzione del personal computer

- AmigaOS ed il Sistema multitasking

- La marcia dei pinguini figli di UNIX: il kernel Linux

- OS X

- Symbian OS

- Blackberry OS

- Windows Phone

- Android

- iOS

- Problemi col tuo iPhone a Milano? Possiamo aiutarti?

Contattaci qui, e ti richiameremo noi!

Quest'articolo è stato aggiornato il giorno: martedì 4 febbraio, 2025

Cos’è un Sistema Operativo?

Ormai l’alfabetizzazione informatica della popolazione mondiale è abbastanza progredita da rispondere con ragionevole accuratezza alla domanda: è il software che permette all’utente di interagire con il calcolatore.

Nell’epoca delle app facili da installare e che praticamente necessitano di zero configurazione da parte dell’utente, la funzione basilare del ‘software principale’ è spesso confusa con l’effettiva utilità dei software che un Sistema può gestire e controllare.

Ad un utente medio, ad esempio, importerà ben poco se il Sistema Operativo del suo smartphone o tablet è basato su un solido kernel monolitico oppure ibrido, così come importerà zero dei complessi sistemi di gestione del multitasking; importerà moltissimo, invece, sapere se determinate applicazioni, come ad esempio Facebook o WhatsApp sono disponibili o meno, se funzionino bene o meno, se siano veloci e reattivi o meno.

In buona sostanza, negli ultimi anni i concetti di Sistema Operativo e quello di programmi su cui esso girano sono diventati sempre più percepiti come ‘unica entità’ dai consumatori, che a volte fanno fatica a distinguere le due cose che, come ogni appassionato di informatica sicuramente saprà, sono invece ben distinte.

La semplificazione moderna del file manager dei Sistemi, inoltre, ha ulteriormente modificato la percezione degli utenti, che sono ormai abituati a considerare le applicazioni dell’OS come parte ‘integrante’ di tutto il Sistema.

In un certo senso, l’idea in sé non è concettualmente sbagliata: l’informatica è stata creata per facilitare la vita, e non per complicarla.

Sotto questo punto di vista, l’evoluzione del calcolo assistito è da considerarsi un successo: i moderni Sistemi Operativi mobili come Android ed iOS, entrati in centinaia di milioni di dispositivi in tutto il mondo, hanno diffuso ancor più capillarmente un’intuizione partita molti, molti anni fa.

L’intuizione di un programma capace di gestire altri programmi, e fare da collante tra utente e puro hardware.

Detta così, ora, sembra semplice da capire, ma il concetto non è di immediata comprensione, e ci sono voluti molti e molti anni di ricerche e studi per implementarlo.

Una storia affascinante che ha permesso, parallelamente al progredire della metodologia costruttiva, di infilare immensi calcolatori un tempo grandi come un piano di un palazzo nelle nostre tasche, sotto la forma dei nostri moderni iPhone.

Una storia che comincia molti decenni fa, quando ancora il concetto di ‘personal computer’ era veramente lontano dall’essere sviluppato, e le porte logiche dei calcolatori erano costruite con enormi (ed instabili) valvole termoioniche.

Le schede perforate ed il progetto ENIAC

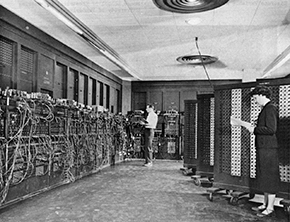

L'ENIAC, ovver il primo calcolatore automatico totalmente elettronico costruito dall'essere umano

Subito dopo la fine della seconda guerra mondiale, lo sviluppo della prima computazione elettronica era affare solo per la ricerca scientifica, in particolar modo applicata ai progetti universitari.

Per via dell’altissimo costo di progettazione e costruzione delle prime macchine da calcolo, tutta la ricerca era concentrata solo nelle istituzioni che potevano realmente permettersi di sborsare ingenti somme di denaro e costo umano nella realizzazione di ingombranti prototipi buoni solo ad eseguire dispendiosi, seppur estremamente interessanti, calcoli matematici.

Solitamente, queste istituzioni erano quasi sempre governative: militari, nello specifico.

Nel 1946, a guerra appena finita e con l’inizio più o meno ufficiale della ‘Guerra Fredda’ con la defunta Unione Sovietica, sotto pressione dei piani alti dello US Army, gli scienziati J. Mauchly e J. Eckert assemblarono ben 18.000 valvole termoioniche sparse su una superficie di 200 mq: era il primo calcolatore totalmente elettronico della storia, ovvero l’ENIAC, acronimo di Electronic Numerical Integrator And Computer.

Inizialmente ideato per calcolare con precisione le traiettorie dei primi prototipi di missili intercontinentali ICBM, l’ENIAC assorbiva così tanta corrente che, alla sua prima attivazione, l’intero quadrante ovest di Filadelfia andò in black-out.

Come tutti i primi calcolatori elettronici, era di dimensioni enormi e non era per nulla affidabile: l’enorme calore dissipato bruciava continuamente le valvole termoioniche; mediamente, se ne fondeva una ogni due minuti.

La potenza di calcolo era risibile, comparata a quella di qualsiasi altra CPU attuale (anche di bassa potenza): i dati ufficiali, complice anche il segreto militare, non sono mai stati del tutto messi a disposizione, ma il grande John von Neumann, durate il calcolo della prima previsione meteorologica della storia, riuscì a fargli processare 250.000 operazioni in virgola mobile in 24 ore.

Una potenza di calcolo assolutamente improponibile, oggi, dove una generica CPU riesce tranquillamente ad eseguire qualche miliardo di operazioni FLOPS al secondo.

Tutti i processori elaborano le informazioni eseguendo semplici calcoli aritmetici di sottrazione, divisione, moltiplicazione, divisione, estrazione delle radici quadrate, ecc ecc., né più e né meno di questo. Solo, eseguono questi calcoli in una quantità enorme, ed in frazioni di secondo (si chiamano cicli CPU).

Per fare ciò,

utilizzano delle particolari combinazioni di piccolissimi diodi e transistor (piccoli davvero, nell'ordine dei nanometri!) chiamate porte logiche.

Tali porte, di differente natura ma che trattano sempre i dati su base binaria (ovvero, solo due valori intesi come variabile), costituiscono il cuore pulsante di un processore, ovvero l'unità ALU (Arithmetic and Logic Unit).

Essenzialmente, l'unità ALU esegue tutti i calcoli aritmetici dei programmi presenti nella memoria (input), e riversa poi il contenuto nella stessa memoria (output), dove verrà poi indirizzato all'utente sotto forma di informazioni di varia natura (video, immagini, suoni, testo, ecc ecc.).

Tante più calcoli al secondo riesce a fare l'unità ALU, tante più istruzioni possono essere eseguite in maniera spedita, e di conseguenza tanto più il calcolatore è percepito come 'veloce' nell'esecuzione dei programmi.

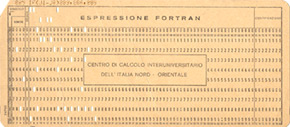

La programmazione dell’ENIAC era affidata alle schede perforate, invenzione risalente addirittura al 1700, quindi ben più antica dell’elettronica: su una scheda in cartoncino, venivano suddivise porzioni e colonne, che potevano essere forate oppure lasciate integre.

Ogni posizione della scheda corrispondeva ad un bit d’informazione, ed una colonna poteva contenere più posizioni.

La scheda era smussata ad un angolo, per impedirne l’inserimento in errata posizione (pericoloso in quanto poteva inceppare la testina di lettura del calcolatore).

Ogni programma scritto sulla scheda perforata doveva essere caricato manualmente sull’ENIAC, e per fermarne l’esecuzione e svuotare la memoria il calcolatore doveva essere spento; questo causava molti problemi, in quanto proprio in fase di accensione e di spegnimento la macchina surriscaldava, e le valvole termoioniche si rompevano.

Su tutte le schede dei programmi era necessario forare tutte le istruzioni necessarie al calcolatore, anche quelle non strettamente attinenti al programma: indirizzi logici ed operazioni I/O dei dispositivi fisici dovevano quindi essere sempre inseriti in qualsiasi programma perché l’ENIAC, come qualsiasi altro calcolatore di quel periodo (o che sarebbe arrivato poco dopo) non aveva nessun ‘programma di base’ (che oggi chiameremo firmware) per gestirsi.

Un concetto assai differente da quello a cui siamo abituati ora.

Una scheda perforata contenente delle istruzioni in FORTRAN

Lentissimo nelle esecuzioni delle istruzioni (che potevano durare anche ore ed ore di calcolo ininterrotte), di dimensioni esagerate e decisamente inaffidabile, l’ENIAC fu comunque il primo vero calcolatore totalmente elettronico della storia.

Un primo passo, decisamente importante, nella rivoluzione informatica.

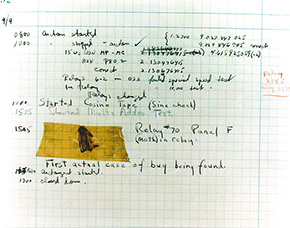

La 'storica' falena incastrata nei circuiti del calcolatore Mark II, che diede origine al termine di 'bug'

In informatica, col termine 'bug' si indica niente meno che un errore nel codice di programmazione, che causa sovente problemi più o meno gravi (da piccoli errori a stampa video fino al crash totale del programma, o addirittura del SO su cui esso gira).

L'origine del nome, che in inglese vuol dire semplicemente piccolo insetto, è tanto curiosa quando semplice: nel 1947, durante un ispezione ad un primitivo calcolatore elettronico, la famosa matematica statunitense, il tenente Grace Hopper (divenuta poi ammiraglio) notò che una piccola falena era rimasta intrappolata tra i circuiti, causando il malfunzionamento della macchina.

La Hopper, nel suo rapporto, prese l'insetto, lo appiccicò su un foglio e scrisse sinteticamente: "Primo caso di insetto rinvenuto".

Da quel giorno in poi, il termine bug fu cominciato ad esser usato per indicare un generico errore riscontrabile dall'utente durante l'esecuzione di un programma, tale da causare, come appunto quella sfortunata falena trovata tanti anni fa, un malfuzionamento del calcolatore.

Lo SPOOL ed il primo concetto di ‘software principale’

A partire dalla metà degli anni '50 del 1900, grazie alla rivoluzione dei transistor e dell’effetto transistor (cliccate qui per una spiegazione dettagliata del fenomeno), l’affidabilità dei calcolatori elettronici migliorò sensibilmente, così come sensibilmente diminuirono le dimensioni delle macchine.

I calcolatori cominciarono ad essere prodotti industrialmente, anche se il loro costo era ancora appannaggio solamente di organizzazioni governative (come al solito, principalmente militari), grandissimi centri di ricerca universitaria oppure istituti bancari ed assicurativi (gli unici privati a potersi permettere i costi altissimi della ricerca informatica).

La distinzione tra architettura hardware, ovvero la parte puramente elettronica del calcolatore, e l’implementazione software ancora non era stata sviluppata: tutti i grandi computer del tempo, chiamati mainframe (nome che sarà utilizzato fino ai giorni nostri, seppure con altri significati), erano costruiti per eseguire determinati calcoli, le istruzioni dei programmi, ed il programmatore doveva avere una conoscenza pressoché totale della macchina: non esistevano concetti come librerie condivise, API, framework e tutti i servizi che ora come ora permettono di programmare anche avendo una conoscenza astratta dell’hardware.

I programmi venivano quindi ideati su carta, trasposti sulle schede perforate ed eseguiti senza soluzione di continuità dalla CPU: l’applicazione prendeva il controllo totale del calcolatore quando era in fase di esecuzione.

La memoria era sempre impegnata, sia durante il caricamento dei programmi che durante la stampa dei risultati, e questo rendeva l’esecuzione di ogni processo un affare lunghissimo.

Sul finire degli anni ’50, alcuni tecnici dell’IBM, all’epoca non ancora colosso mondiale ma azienda di belle speranze, si resero conto di un fatto: le loro CPU erano tutto sommato abbastanza veloci (per l’epoca) nell’eseguire i calcoli ma, una volta che i risultati erano disponibili, la stampa di essi generava un tempo d’attesa molto lungo, e soprattutto infruttuoso: la CPU in effetti aveva già finito di calcolare, ma la memoria era tutta occupata nell’inviare i dati alla stampa.

C’erano quindi due differenti velocità d’esecuzione del calcolatore: la prima, veloce, di calcolo puro; la seconda, infinitamente più lenta, di output dei dati.

Un po’ come partire da casa la mattina con la nostra autovettura e, miracolosamente, non trovare alcun traffico sulla tangenziale, salvo poi rimanere imbottigliati due ore proprio sotto l’ufficio, per via del più lento traffico locale.

Studiando un po’ la questione, gli ingegneri trovarono la soluzione del problema che rallentava di molto l’esecuzione dei programmi: suddivisero la memoria totale in differenti ‘sezioni’, e ne riservarono alcune solamente per un compito preciso, ovvero quello di accettare i dati elaborati dalla CPU ed inviarli alla stampa.

Datosi che la connessione tra CPU e stampante era infinitamente più lenta della connessione memoria/CPU, l’area di memoria dedicata era istruita per lavorare autonomamente, a velocità differente, più lenta, rispetto alle altre aree.

Era nato il primo buffer della storia.

Utilizzando il buffer, si ottenevano innumerevoli vantaggi: il processore, una volta finito di elaborare le istruzioni, inviava tutto alla memoria tampone, che poi provvedeva, con tutta tranquillità, ad inviare i risultati alla stampa; mentre ciò accadeva, l’altra memoria poteva continuare a dialogare col processore, eseguendo altri calcoli a velocità superiore a quella del buffer.

Tali istruzioni erano eguali per ogni programma, che ne giovava sensibilmente nei tempi d’esecuzione: libera dai inutili attese, la CPU poteva sempre eseguire il suo ciclo alla massima velocità possibile.

Queste istruzioni automatiche vennero gradualmente incluse in ogni programma, creando il primo SPOOL della storia: Simultaneous Peripheral Operations On-Line, per l’appunto.

Non passò molto tempo per intuire che le istruzioni dello SPOOL, valide per ogni programma ed obbligatoriamente inserite nello stesso, effettivamente potevano essere considerate come un vero e proprio programma a sé stante.

Era l’inizio degli anni ’60, e proprio grazie allo SPOOL cominciò a balenare nella testa degli ingegneri elettronici dell’epoca il concetto di ‘software di base’ (o ‘principale’).

IBM BOS/360

Un terminale IBM S/360 col BOS/360 in esecuzione

Nella metà degli anni ’60, l’IBM presentò sul mercato una linea di calcolatori decisamente rivoluzionaria: la famiglia System/360 (abbreviata come S/360), passata alla storia come la prima, vera linea di calcolatori a proporre una netta distinzione tra architettura hardware ed implementazione software.

Tutte le macchine della famiglia, difatti, venivano già vendute con un software ‘di base’ installato nelle loro memorie di massa: il BOS/360, acronimo di Basic Operating System/360 (Software Operativo di Base/360).

Tale concetto era una novità per il settore: per la prima volta, un programmatore poteva anche non conoscere nel dettaglio assoluto l’architettura della macchina, perché molte parti di essa erano governate direttamente dal BOS/360, ed un generico programma doveva solo richiamarle per l’esecuzione.

Si assisteva quindi ad un passaggio fondamentale nella storia dell’informatica: la piattaforma hardware, ovvero la parte puramente elettronica del calcolatore, era distinta dalle istruzioni che essa doveva eseguire, ovvero il software.

Era nata la prima bozza di Sistema Operativo propriamente detto, che IBM poi continuò a perfezionare e migliorare nel corso degli anni.

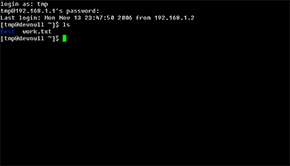

UNIX

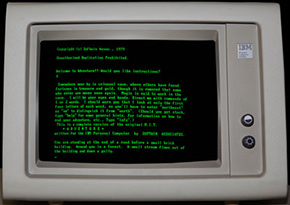

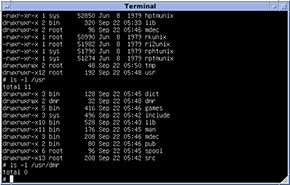

Una tipica interfaccia del terminale (shell) a linea di comando di UNIX

Sul finire del 1969, nei laboratori di ricerca Bell, un giovanissimo Ken Thompson (l’hacker famoso per aver dato vita all’ancor più famoso linguaggio di programmazione C), per poter eseguire un programma di astronomia, scrisse la prima traccia di un software destinato, in pochi anni, a divenire il più famoso Sistema Operativo multiutente: UNIX.

Migliorato ed espanso nelle funzionalità nel corso degli anni (i suoi miglioramenti continuano ancora con i suoi ‘eredi moderni’, ovvero OS X, Linux, Android ed iOS), UNIX era ed è ancora un Sistema estremamente avanzato per ciò che concerne sia la gestione propria della macchina da parte degli utenti, sia per l’esecuzione dei programmi degli stessi.

Sistema ideato fin dall’inizio come multi-utente, permetteva una gestione dislocata di utenti su più terminali collegati allo stesso mainframe, cosa che fin da subito esaltò il mondo della ricerca, in particolar modo quello universitario.

AT&T, proprietaria dei laboratori Bell ed al centro di forti polemiche per la sua posizione dominante nel settore delle telecomunicazioni, decise di rilasciare UNIX gratuitamente, senza royalty, a chiunque ne facesse richiesta per motivi di studio o ricerca: bastava pagare solo la spedizione ed il supporto magnetico su cui risiedeva il Sistema.

Questo permise, in brevissimo tempo e con costi molto contenuti, l’accesso universale del nuovo OS alle grandi università americane in primis, e di tutto il mondo poi.

Con l’ascesa del progetto militare ARPANET, poi divenuto Internet, la diffusione e la condivisione di UNIX divenne facile e totale.

I due progetti, sia ARPANET e UNIX, condivisero praticamente lo stesso percorso di sviluppo: molti dei concetti, anche basilari, che si trovano su molti servizi Internet sono direttamente derivati da UNIX, così come molte innovazioni dell’Internet (basti pensare alle repository) sono stati implementati praticamente da subito in UNIX.

Già sul finire degli anni ’70 del 1900, praticamente tutti i calcolatori mainframe dei più grandi cerchi di ricerca ed universitari del mondo erano collegati con il protocollo TCP/IP e si scambiavano le informazioni su host in cui girava UNIX.

Il concetto di ‘personal computer’ era ancora abbastanza lontano dall’essere immesso sul mercato da Steve Jobs e dal primo calcolatore Macintosh, ma grazie alla portabilità di UNIX c’era già un Sistema Operativo portabile, facilmente adattabile a qualsiasi hardware, solido ed estremamente duttile.

Attualmente, il kernel puro originario di UNIX non è quasi più usato a livello consumer, ma vive lo stesso in una quantità di kernel derivati: FreeBSD, Linux, OS X, Android, iOS tanto per citare solo i più famosi.

Con oltre 200 milioni di calcolatori desktop e laptop venduti, OS X è la versione di UNIX di maggior successo e di più ampia base d'installazione nella storia, mentre a livello mobile Android e iOS raggiungono la quota spaventosa di oltre un miliardo (!) di dispositivi con kernel derivato da UNIX penetrati tra le masse.

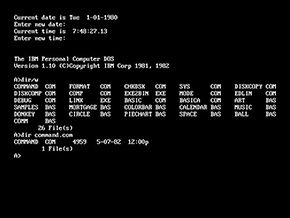

MS-DOS

Una schermata d'esempio dell'interfaccia a linea di comando di MS-DOS.

Praticamente ogni ragazzo o bimbo cresciuto sul finire degli anni '80 e l'inizio degli anni '90 ha avuto a che fare con tale Sistema Operativo

Nel 1980, l’IBM aveva messo a punto il primo abbozzo della sua idea di ‘personal computer’, ovvero un calcolatore dal costo alto ma accessibile, di dimensioni ridotte ed adatto per essere implementato come macchina da calcolo tuttofare per uffici, aziende ed imprese varie (anche utenze private).

Come quasi tutti i produttori dell’epoca, IBM traeva i guadagni più grossi del suo business dalla vendita hardware, mentre i ricavi di assistenza e software erano molto più modesti, e perciò sacrificabili; i dirigenti decisero così, una volta pronta la nuova architettura, di rivolgersi ad una software house esterna per lo sviluppo di un Sistema Operativo dedicato.

Si rivolsero quindi ad una giovane azienda di Redmond, recentemente salita alle cronache per aver prodotto un buon interprete BASIC, ovvero la Microsoft dei giovanissimi Bill Gates e Paul Allen.

I due hacker compilarono in breve tempo circa 4000 linee di codice assembly per il nuovo processore della serie X86 dell’Intel, su cui si fondava la nuova architettura IBM, e quest’ultima rimase molto soddisfatta del lavoro svolto.

Il nuovo Sistema Operativo fu chiamato MS-DOS, ovvero l’acronimo di Microsoft Disk Operating System e, grazie al basso prezzo di commercializzazione (meno di $ 40.00), fu un successo mondiale: i clienti che comperavano un nuovo PC IBM potevano, con poca spesa in più, avere anche il Sistema Operativo incluso nel costo del calcolatore, e questo ne decretò la riuscita commerciale.

Successivamente gli ingegneri IBM modificarono parte del codice di MS-DOS, e svilupparono una versione parallela chiamata PC-DOS: entrambe le versioni continuarono a co-esistere sul mercato per oltre un decennio.

Fino all’inizio degli anni ’90, Microsoft ed IBM detenevano con il DOS oltre il 90% del mercato degli OS per personal computer.

Un dominio che proseguirà ancora per molti anni, fino all’avvento della rivoluzione mobile degli anni 2000.

Uno degli ambienti grafici più popolari sotto MS-DOS: il Norton Commander.

Sebbene anch'esso prettamente testuale, dotata MS-DOS di un file manager molto più comprensibile e diretto

MS-DOS era un Sistema Operativo decisamente schematico: monoutente e monotasking, ciò capace di eseguire un solo programma (task) per volta, era comunque semplice da gestire anche per un utente poco esperto.

Girava su processori X86 e compatibili, rigorosamente a 16 bit ed ogni processo avviato prendeva il totale controllo del Sistema: un rischio accettabile per le utenze domestiche, ma una scelta improponibile per aziende ed istituti di ricerca, che difatti gli preferirono sempre il più solido UNIX.

L’interfaccia utente standard era una shell a linea di comando, che praticamente tutti gli utenti ben presto rimpiazzarono con l’ambiente grafico Microsoft Windows od il famoso Norton Commander.

Con l’avvento di Windows 95, MS-DOS fu implementato in esso sotto forma di batch, ovvero una shell richiamabile direttamente dal file manager di Windows.

Rimase supportato ufficialmente da Microsoft fino al 2000, anche se il suo utilizzo pratico, nel mondo, finì già con Windows 98.

Poco costoso, dalla semplice gestione e tutto sommato efficiente per un’utenza domestica, MS-DOS è stato il Sistema con cui è partita la prima rivoluzione informatica per le masse della storia: non era niente di eccezionale, e molti altri Sistemi a lui contemporanei lo surclassavano sotto ogni aspetto, ma ebbe l’indubbio pregio di far avvicinare molta gente all’informatica ‘da salotto’, e non solo da centro di ricerca e sviluppo universitario.

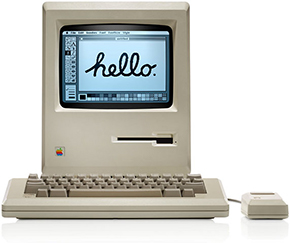

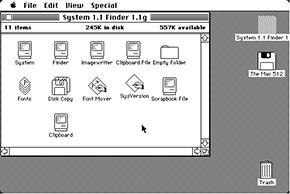

Mac OS e la rivoluzione del personal computer

1984, primo Macintosh della storia: nasce l'idea del 'personal computer'

Nel 1984, un allora giovanissimo Steve Jobs, con una famosa campagna di marketing entrata di diritto nella storia della comunicazione, presentò al mondo il primo calcolatore della nuova famiglia Macintosh: era il Macintosh 128K, primo computer compatto (all-in-one, diremmo ora), dal costo accessibile e con mouse ed interfaccia grafica di serie.

Fu immediatamente un grandissimo successo: l’intuizione di Jobs di dedicarsi totalmente ad un’interfaccia grafica con con pieno supporto WIMP (Windows, Icons, Mouse, Pointer) facilitava di molto il rapporto macchina/utente, specie in un periodo in cui l’informatica era una passione coltivata dalla sparuta minoranza della popolazione mondiale, e le nozioni principali del calcolo elettronico, ormai considerate basilari per gran parte della gente, erano al tempo invece quasi del tutto ignorate.

La prima versione del Mac OS, ovvero il Sistema Operativo storico di Apple (chiamato al tempo semplicemente System Software, ovvero software di Sistema) introduceva novità fondamentali nell’approccio uomo/calcolatore, che nel tempo sarebbero poi diventate standard per tutti gli altri Sistemi Operativi: concetti come scrivania, cartella, cestino et similia.

Il nuovo dispositivo di puntamento ottico, il mouse, rendeva poi molto facile ed intuitiva l’interazione occhio/mano: l’utente aveva la piena convinzione di ‘controllare’ ciò che vedeva a schermo, e questo era di estrema importanza, specie per chi (si pensi agli impiegati d’ufficio, o alle segreterie aziendali) non aveva mai avuto alcun approccio con l’informatica.

Una tipica finestra del Mac OS prima versione: si notano elementi ormai di uso familiare, come vestino, scrivania e cartelle

Il Mac ed il Mac OS furono un ottimo successo per tutti gli anni ’80, e l’inizio della rivoluzione del ‘personal computer’, ovvero una macchina accessibile da qualsiasi persona (sia come costo che come utilità) per convenzione si fa coincidere proprio con la presentazione del primo 'Mac'.

Mac OS fu un Sistema incredibilmente longevo: fu supportato e continuamente migliorato fino all’inizio degli anni 2000, anche con discrete difficoltà tecniche (aveva un obsoleto sistema di gestione del multitasking e svariati altri difetti strutturali).

Dal 2001 fu completamente sostituito dal suo erede (anche se quasi solo ‘di nome’), ovvero Mac OS X, in seguito diventato semplicemente OS X.

L'ultima versione del Mac OS, la 9.2, prima del pensionamento

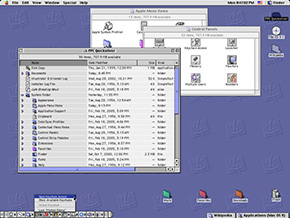

AmigaOS ed il Sistema multitasking

Il primoWorkbench della storia di AmigaOS

Nel 1984, quando ormai il così detto ‘home computer’ stava lasciando il posto al ‘personal computer’ la Commodore, all’epoca leader degli home computer a basso costo e con una base di calcolatori piazzati nel mondo pazzesca (soprattutto, i famosi Commodore 64 e Commodore 128) sborsò fior di milioni di dollari per acquisire dalla Hi-Toro del famoso Jay Miner una piattaforma hardware per il tempo davvero rivoluzionaria: l’Amiga.

Il progetto era anni luce avanti anche al primo Mac presentato da Jobs: hardware con processore a 16 bit (della famiglia Motorola 68k) e, cosa unica ai tempi e concetto che poi sarebbe stato sviluppato da tutti negli anni a venire, una serie di chip dedicati collaboranti con la CPU principale.

I chip ausiliari (co-processori, li avremmo chiamati ai nostri tempi) erano assemblati in uno schema chiamato OCS (Original Chip Set), e esentavano la CPU da tutti quei calcoli avanzati e dedicati per video, audio; una cosa veramente innovativa e tecnologicamente di altissimo livello, ai tempi.

Il Sistema Operativo, AmigaOS, era altrettanto stupefacente: era multitasking reale, e l’interfaccia grafica era talmente avanzata che permetteva di assegnare una scrivania dedicata per ogni applicativo in esecuzione: un’innovazione che sarebbe stata introdotta negli OS di Apple e Microsoft circa 20 anni dopo.

L’ambiente di lavoro di chiamava Workbench, e presentava interessanti caratteristiche come un’interfaccia colorata (quattro colori, con risoluzione 600 X 256 in PAL), comandi direttamente nelle finestre delle applicazioni che poi sarebbero diventati standard in ogni GUI (Salva, File, Modifica, ecc ecc.) e, incredibile per l’epoca, anche effetti d’ombre che simulavano l’effetto 3D.

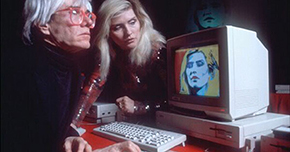

Il primo calcolatore Amiga realizzato e commercializzato: l'Amiga 1000.

Il design del case e del monitor fu realizzato da Andy Warhol

Il progetto Amiga fu subito un grandissimo successo: l’hardware era di svariate grandezze superiore a qualsiasi home computer prodotto nel periodo, e l’ambiente Workbench, a cui Windows poi si sarebbe palesemente ispirato, permetteva un facile controllo del calcolatore anche per i neofiti dell’informatica.

Molte delle funzioni che siamo ora soliti trovare sui nostri OS moderni sono derivate pari pari da AmigaOS: basti pensare al concetto di ‘dock’, divenuto famoso con OS X prima e con gli OS mobili poi, oppure le multi-scrivanie, ognuna con i suoi applicativi in esecuzione (o background).

Il grande artista Andy Warhol fu un entusiasta del sistema Amiga, tanto da curarne non solo la presentazione commerciale, ma anche il design esterno.

Warhol, intuite prima di ogni altro le potenzialità immense di un Sistema con interfaccia GUI, fu un utente appassionato della macchina fin sino alla sua morte, avvenuta nel 1987

Col fallimento di Commodore nei primi anni ’90 - fallimento che ancora oggi in molti non riescono a spiegarsi - purtroppo la piattaforma Amiga ed il suo software, proprietario e non di libero accesso, sono andati via via morendo: il monopolio pressoché totale di Windows prima e di Apple poi non hanno lasciato scampo ad un OS decisamente di livello, che avrebbe meritato forse più fortuna a livello mainstream.

La marcia dei pinguini figli di UNIX: il kernel Linux

Tux, la mascotte del kernel Linux

Nel 1991, dopo un accesa discussione ormai passata alla storia con un suo professore universitario, il giovane studente finlandese Linus Torvalds s’impegnò nello scrivere il kernel (ovvero il nucleo essenziale di un generico Sistema Operativo) di quello che, secondo lui, sarebbe dovuto essere un buon Sistema per l’architettura Intel i386, all'epoca molto economica ed accessibile a praticamente tutti.

Datosi che l’OS di ricerca e studio del suo professore Andrew Tanenbaum, il celebre Minix, per la sua natura di micro-kernel non riusciva a sfruttare al massimo le potenzialità del chip Intel, Torvalds approntò un diverso approccio, scegliendo un kernel puramente monolitico (una scelta all’epoca giudicata in contro-tendenza rispetto al mercato, orientato verso Sistemi invece ibridi).

Al nuovo kernel venne dato il nome di Linux, ed inizialmente era nulla più che un terminale testuale, ma già nel 1992, grazie anche all’apporto di programmatori esterni, Torvalds poté rilasciare una versione con uno stack di rete.

L'ambiente grafico GNOME in una distribuzione di GNU/Linux

Appoggiandosi ai software liberi del progetto GNU iniziato dal famoso Richard Stallman una ventina d’anni prima, il puro kernel di Linux poté essere integrato con il software GNU, per formare un vero Sistema Operativo: GNU/Linux.

A differenza dei software proprietari prodotti da Microsoft ed Apple (solo per citare i due produttori più famosi), GNU/Linux è messo a disposizione degli utenti per mezzo di distribuzioni: ogni distribuzione, che può essere gratuita oppure a pagamento, incorpora comunque il kernel Linux e tutto il software fondamentale del progetto GNU, mentre i pacchetti aggiuntivi possono variare da distribuzione a distribuzione.

Sebbene non molto diffuso in ambito consumer desktop, il kernel Linux ha visto una vera e propria esplosione mondiale quando Google decise di usarlo come base per il suo Android, installando così il lavoro di Torvalds in milioni di dispositivi mobili.

Una comune bash di GNU/Linux.

Molti dei comandi di Linux sono derivati da UNIX, e funzionano pressoché allo stesso modo

A livello d’esperienza d’uso, GNU/Linux si presenta come un OS molto solido: la derivazione da UNIX lo rende multitasking e multiutente per natura, così come favorisce molto la sicurezza di tutto il Sistema; la memoria di swap, tipica di tutti i derivati di UNIX, è storicamente sempre ben implementata, e permette una gestione agevole del calcolatore anche con hardware non così esaltanti.

Nel corso degli anni, anche gli ambienti grafici che da sempre hanno accompagnato GNU/Linux si sono evoluti: GNOME e KDE, le GUI più diffuse per il Sistema, ormai hanno raggiunto eccellenti livelli, sia prettamente grafici che d’interazione con l’utente.

GNU/Linux è un Sistema che, per la sua notoria stabilità e per l’ottima sicurezza intrinseca che offre da sempre, è particolarmente apprezzato come OS per macchine server: anche IBM, nel corso degli anni, ha gradualmente spostato le sue preferenze verso soluzioni GNU/Linux, in alternativa a quelle con Microsoft Windows.

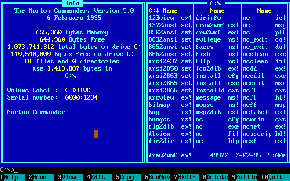

OS X

OS X, il Sistema Operativo derivato da UNIX con la più ampia base installata nel mondo

Sul finire degli anni ’90 del 1900, Apple si ritrovò con un problema enorme, ingigantitosi a dismisura nel corso degli anni, complice scelte sbagliate, direttive d’azienda ancora più sbagliate e, tanto per non farsi mancare nulla, una concorrenza spietata di Microsoft, che con il suo Windows aveva ormai cannibalizzato quasi tutto il mercato degli OS a livello mondiale.

Il problema di Apple era semplice: il Mac OS, lo storico Sistema della mela, aveva raggiunto insormontabili limiti strutturali di sviluppo.

Ancorato ancora ad un multitasking senza prelazione (il cooperativo), di vecchia concezione con le estensioni di Sistema caricate nella fase di boot (follia, ai giorni nostri) e con un supporto di rete obsoleto, Mac OS X non riusciva davvero a stare al passo dell’onda anomala chiamata Windows.

Così Apple si ritrovò con un paradosso curioso: un hardware decisamente potente (i nuovi processori RISC PowerPC erano di ottimo livello), strozzato però da un OS che ormai aveva fatto il suo tempo.

Con la seconda venuta di Jobs, le cose cambiarono: il nuovo CEO della mela, ripreso il comando della sua azienda, mise senza troppi rimpianti in soffitta il vecchio Mac OS classico e presentò il nuovo Mac OS X.

Mac OS X 10.1, nome in codice Puma, ovvero la prima versione di OS X veramente usabile (anche se ancora molto lenta)

Il nome è volutamente un giochetto di parole: X sta per dieci in numeri Milanoni, ma anche per UNIX, da cui il core del sistema, Darwin, è derivato.

Jobs fuse quanto di buono aveva fatto prima con la sfortunata NeXTStep e con la versione FreeBSD di UNIX, per dar vita ad un kernel ibrido, solidissimo e con un’interfaccia grafica che avrebbe fatto scuola: Aqua.

Fu presentato in anteprima nel 1999 e, dopo una beta pubblica durata quasi un anno, nel 2000 fu commercializzato con la release stabile.

Non ebbe inizialmente molto successo, vuoi per il fatto di non essere compatibile con i software del vecchio Mac OS (se non in emulazione), vuoi per il fatto che le prime due revisioni di Sistema erano ancora troppo lente e pesanti.

Le cose cambiarono radicalmente nel 2002, quando fu introdotto l’aggiornamento Mac OS X 10.2, ovvero Jaguar: un Sistema incredibilmente stabile, veloce e potente, con finalmente molti importanti software nativi immediatamente disponibili.

Mac OS X 10.4 Tiger, la prima versione di Mac OS X a girare su processori Intel X86

Il nuovo Sistema era basato ampiamente su UNIX, e si vedeva: multiutente nativo, i sistemisti UNIX potevano interagire con la shell di comando senza troppi problemi, in quanto i comandi erano essenzialmente gli stessi.

Il multitasking era finalmente con prelazione (preempitive), e la memoria di swap era intelligentemente implementata con un ingegnoso sistema di immagini disco gestite da un demone specifico: quando lo spazio per la virtualizzazione della memoria stava esaurendosi, un demone creava un nuovo file immagine più grande in cui travasava il contenuto di quello vecchio, che poi avrebbe cancellato.

Semplice e funzionale.

Mac OS X 10.5 Leopard, in grado di girare sia su processori PowerPC che su processori Intel X86.

Mac OS X soppiantò il vecchio Mac OS nel giro di pochi anni: nel 2005, Apple mandò ufficialmente in pensione l’ambiente Classic e, non contenta, rottamò pure i processori PowerPC, passando agli Intel (una svolta storica). OS X venne quindi riscritto per l'architettura X86, e per un breve periodo fu disponibile per entrambe le famiglie di processori, sia PowerPC che Intel grazie alla compilazione Universal Binary.

L'ultima versione di Mac OS X

compatibile con i PowerPC è Mac OS X 10.5 Leopard: da quella release in poi, OS X sarà compatibile solo con i nuovi processori Intel a 64bit.

Mac OS X 10.11 El Capitan, con il suo inconfondibile look stile iOS

OS X segna un passaggio importante nella storia di Apple ed anche dell'informatica moderna: per la prima volta, un Sistema UNIX entrava nel mercato consumer di massa.

Diverrà, nel corso degli anni, il Sistema UNIX desktop con la più ampia installata nel mondo.

Symbian OS

La più famosa versione di Symbian OS, montata su milioni di dispositivi: Symbian S60

All'inizio degli anni 2000, il mercato della telefonia cellulare era dominato in pratica da una sola azienda: la finlandese Nokia.

Tale storico marchio, nell'apice del suo successo (attorno al 2006) aveva circa il 40% dell'intera produzione mondiale di telefoni mobili: una quota di mercato pazzesca, con una produzione di modelli sterminata.

Sul finire degli anni '90 del 1900, in piena rampa d'ascesa, Nokia decise di adottare, per i suoi primi dispositivi 'avanzati' (all'epoca, il termine 'smarphone' ancora non era stato coniato) un OS progettato da Symbian Limited, una piccola azienda erede di Psion Software, che aveva accumulato una discreta esperienza di progettazione per firmware di calcolatrici e palmari, e che aveva poi deciso di sviluppare un sistema proprietario per cellulari: Symbian OS, per l'appunto.

Per il periodo, Symbian OS era un Sistema molto avanzato: era scritto in C++, ma poteva essere programmato anche in Python, Ruby, Java ME, persino ActionScript; era multitasking, multi-lingua (includeva di default praticamente tutti gli idiomi più parlati al mondo), orientato ad essere espanso con programmi di terze parti (quelle che saranno poi conosciute come 'app' nei Sistemi moderni).

I programmi aggiuntivi potevano essere scritti in Java, e questo ne rendeva lo sviluppo molto veloce ed apprezzato dai programmatori.

In principio non esisteva un vero e proprio store digitale ma, come usanza dell'epoca, i programmi potevano essere scaricati direttamente dal web, oppure scaricati su un calcolatore esterno e inviati al Symbian tramite connessioni Bluetooth o via cavo (potevamo essere inviati anche via MMS).

Questo causava molti problemi di sicurezza, che Nokia cercò di arginare dapprima obbligando gli sviluppatori a certificare digitalmente le applicazioni, e poi creare uno store digitale (OVI Store, poi ribattezzato Nokia Store) per il download ufficiale dei contenuti.

L'interfaccia grafica richiamava quella dei Sistemi desktop dell'epoca: cartelle, icone, menu contestuali, ed era progettata per essere usata con una comune tastiera 0-9 (inclusi i tasti funzione).

Assieme a Nokia, altre grandi aziende come Sony-Ericsson cominciarono ad adottare Symbian OS come Sistema per i loro dispositivi, tanto da formare poi una holding (la Symbian Foundation) per garantirne lo sviluppo costante.

I primi smartphone prodotti da Nokia che garantivano un vero accesso 'multimediale' per l'utente, montavano tutti il Symbian OS: il famoso Nokia 6600, considerato da molti come il primo vero smartphone con caratteristiche comparabili a quelle moderne, montava Symbian OS S60.

Purtroppo, complice anche la scossa pazzesca che diede Apple col suo iPhone e l'inizio dell'ascesa di Android, Symbian OS fu scaricato in fretta e furia da pressoché tutti i produttori mondiali.

L'unica azienda che lo tenne sino alla fine fu proprio la Nokia, e con le conseguenze nefaste per la compagnia che tutti conosciamo e che la portarono ad essere comperata per un cifra risibile dalla Microsoft.

Attualmente lo sviluppo di Symbian OS è concluso: i diritti del software appartengono alla multinazionale Accenture, che tuttavia ne ha dichiarato (ufficiosamente) morto il progetto.

L'ultimo aggiornamento del Sistema risale al 2011, con Symbian^3 Nokia Belle.

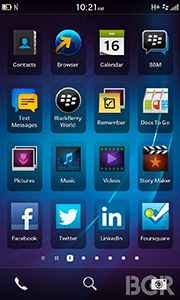

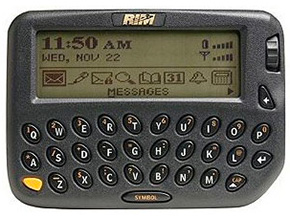

Blackberry OS

BlackBerry 10

Nel 1999, in un mercato della telefonia mobile ancora quasi tutto da conquistare, e in un periodo in cui l'Internet stava per esplodere definitivamente nel mercato casalingo (in quello aziendale ed industriale era già entrata da un bel pezzo), l'ingegnere elettronico Mike Lazaridis ebbe un'idea vincente in ambito business: integrare in un dispositivo cercapersone un software client di messaggistica e-mail (vera e propria innovazione del periodo).

Fondò quindi la sua compagnia, la Research in Motion (conosciuta semplicemente come RIM) e commercializzò il primo prodotto, il BlackBerry 850.

Tale dispositivo aveva caratteristiche uniche: una tastiera completa QWERTY, una rotella di controllo per scorrere sopra e sotto i messaggi e, soprattutto, un'integrazione server dedicata, la prima con tecnologia push.

Il BlackBerry 850, il primo cercapersone dotato di connettività push

Il dispositivo ottenne quasi subito un unanime consenso dal mondo business, soprattutto per la comodità del servizio push delle email.

Complice del grande successo in ambito aziendale, RIM ingradì la propria struttura server e progettò e commercializzò differenti dispositivi, stavolta non più solamente cercapersone ma veri e propri telefoni mobili.

Per essi, venne sviluppato un Sistema Operativo dedicato chiamato BlackBerry OS, che incorpora due servizi essenziali: BlackBerry Internet Service (BIS) e BlackBerry Enterprise Server (BES).

Tutti e due i servizi, pensati per piccole, medie e grandi aziende, permettono ad un dispositivo BlackBerry di usufruire degli account aziendali di posta, con il servizio di notifiche push; una soluzione comoda per l'azienda, che così può anche sincronizzare calendari e contatti.

In un mondo ancora privo del cloud computing, i servizi push di BlackBerry risultavano estremamente utili per le imprese, e questo ne decretò il successo commerciale.

Successo che però rimase confinato all'utenza business, senza uscire di molto dal settore meramente professionale; questo forse fu un grosso errore da parte di RIM, che non pensò mai di espandere seriamente il suo prodotto verso altri lidi, in particolar modo quelli consumer.

Con l'avvento di iCloud e dei GMS di Google (e del cloud computing in generale), i servizi BIS e BES di BlackBerry

persero molto del loro 'appeal'; anche il software BlackBerry OS rimase decisamente al palo: quasi ignorato dalla stragrande maggioranza dei programmatori, il Sistema già sul finire degli anni 2000 soffriva di una carenza atavica di applicativi di largo consumo, presenti su Android ed iOS ma mai implementati nella piattaforma di RIM.

Vedendo crollare a picco la quota di mercato, l'azienda corse ai ripari nel 2013: si rinominò BlackBerry Limited e introdusse sul mercato il nuovo BlackBerry 10, la versione dell'OS che, stando ai piani aziendali, avrebbe dovuto colmare il gap accumulato con Android ed iOS.

Il nuovo software purtroppo non riuscì a risollevare BlackBerry da una situazione di mercato imbarazzante: meno del 6% totale di quota spartita.

Al BlackBerry OS, comunque, va il merito di aver iniziato a sviluppare un concetto differente per la gestione della posta e dei contatti aziendali: un concetto che poi sarebbe stato implementato sia da Apple che da Google nei loro OS.

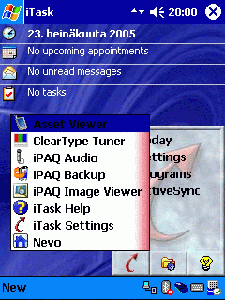

Windows Phone

Una delle prime versioni di Microsoft Pocket PC, che poi sarebbe diventato Windows Mobile

A cavallo tra la fine del 1900 e l'inizio del 2000, complice anche un mercato della telefonia in piena espansione (con conseguente abbassamento dei prezzi di produzione, sia di beni che di servizi), Microsoft fiutò l'affare e pensò bene di sviluppare una versione mobile del suo software di punta, ovvero Windows.

I primi dispositivi con il primo software mobile di Redmond installato furono chiamati Pocket PC, e l'OS era essenzialmente un misto tra Windows 98 e una versione ampiamente modificata di PalmOS, il celebre OS dei dispositivi portatili della Palm.

All'epoca il touchscreen non era pensato per essere usato direttamente con le dita, ma con una stilo apposita: il Sistema quindi era scomodo da usarsi

con le mani, e rendeva al meglio solo col la stilo.

Microsoft migliorò e perfezionò il suo Pocket PC per tutto il corso degli anni 2000, ribattezzandolo Windows Mobile e fornendolo delle estensioni adatte a farlo competere con iOS ed Android.

Il progetto non riuscì: gli ingegneri di Redmond, benché qualificati, non avevano molta esperienza nel settore mobile e si vedeva chiaramente.

Windows Mobile 5

Nel 2010,

in un mercato mobile che vedeva Windows Mobile semplicemente non esistere (con percentuali di mercato irrisorie), Microsoft decise di cambiare totalmente strategia: supporto solamente al mercato degli smartphone, OS totalmente rivisto e riprogettato, rinominato Windows Phone, piena autonomia dalla versione desktop e, soprattutto, 'hardware dedicato'.

Non passò poco tempo per capire cosa 'hardware dedicato' volesse significare, nei piani della società di Redmond: nel 2011, Microsoft annunciò una stretta partnership collaborativa con Nokia, per la produzione e la distribuzione di telefoni smartphone di costruzione finlandese ma con software Windows Phone.

La notizia in realtà nascondeva una verità ben differente: Microsoft stava tendando di comprare tutto il pacchetto Devices & Services' di Nokia.

Con una mossa incredibile ed un esborso economico tutto sommato modesto (per Microsoft) di circa 5 miliardi di Euro, l'azienda americana potè finalmente rimettersi in corsa sul mercato mobile, acquisendo di colpo tutti i migliaia di brevetti di Nokia (un tesoro unico al mondo), tutte le sue risorse umane e tutta la sua infrastruttura mobile.

Windows Phone 8.1

Così, nel 2011, uscirono i primi cellulari Lumia prodotti da Nokia con Windows Phone 7 installato come OS, ed il mercato reagì tutto sommato positivamente alla proposta.

Il Sistema aveva una GUI decisamente differente rispetto alla concorrenza di Android ed iOS, e riprendeva molto il classico menù Start di Windows.

Le applicazioni e le impostazioni di Sistema erano accessibili tramite icone modulari, e buona parte della grafica la componeva il font del testo, in un'impostazione chiamata Metro.

Il nuovo Sistema era all'inizio non così veloce e reattivo: ci vollero molti aggiornamenti ed un salto di numero di versione (l'ottava) per portarlo ad essere pienamente usabile.

Con Windows 8, inoltre, Microsoft cercò di unire i due Sistemi in un più ampio 'eco-sistema' funzionale: molti degli elementi grafici di Windows Phone vennero implementati, non senza ruvida imperizia purtroppo, nella nuova GUI della versione desktop, che rese Windows 8 una delle peggiori release dell'OS di Redmond.

Microsoft corse ai ripari con la versione 8.1, che migliorava di molto l'esperienza (abbastanza frustante, a volte, specie in ambito desktop), ma che ancora lasciava molto amaro in bocca agli utenti.

Windows Mobile 10

Tutto l'eco-sistema fu rivisto con la versione 10 di Windows: il Sistema venne nuovamente rinominato Windows Mobile, e vennero apportate diverse migliorie sia nell'interfaccia grafica che nella gestione degli applicativi.

Microsoft Edge prese il posto di Internet Explorer, e i due store digitali, sia per la versione desktop che quella mobile furono unificati.

Sicuramente diventato un ottimo sistema, con continui aggiornamenti e con continui miglioramenti sostanziosi fatti nel corso degli anni, Windows Mobile continua però a soffrire di un preoccupante ritardo accumulato da Microsoft nella 'corsa al mobile': tutte le sue funzioni principali scontano ancora una gestione non ottimale rispetto alle controparti Android ed iOS, e questo si traduce in volumi di vendita e basi installate molto bassi, se paragonati a quelli dei suoi antagonisti principali.

Android

L'androide stilizzato usato come logo di Android

Nel 2003 lo statunitense Andy Rubin, intuendo le grandi potenzialità ancora inespresse della telefonia mobile, fondò una microscopica start-up (l'Android Inc.) con l'obiettivo di sviluppare un Sistema Operativo veloce, a scalare e soprattutto libero dai vincoli prettamente hardware dei produttori di telefoni.

Lo sviluppo del Sistema, cominciato davvero con modica spesa (circa $ 10,000) fu notato dai ragazzi di Google che, interessati nell'entrare nel business del mercato mobile (al tempo, un settore dominato quasi esclusivamente da Nokia), stavano giusto cercando una buona base per iniziare.

L'Android Inc. fu quindi comperata da Google, e Rubin diventò vicepresidente della sezione ingegneria. Potè così continuare a sviluppare il suo OS grazie agli enormi fondi dell'azienda di Mountain View, e nel 2008 fu lanciato sul mercato il primo telefono cellulare Google con sopra il Sistema Android installato: il Nexus One.

La prima versione di Android, la 1.0

Android fu subito un grande successo, dapprima però per i produttori di telefoni: praticamente liberi dalle incombenze (onerose) dello sviluppo di un OS proprietario per i loro dispositivi, società come LG, Samsung e Sony poterono puntare tutto sulla progettazione hardware, con enorme risparmio di risorse e costi.

Android è un Sistema con kernel derivato da Linux e, anche se proprietario, incorpora quasi tutto software proveniente dal mondo open source.

Google rilascia il software gratuitamente, ma si produttori devono acquistare obbligatoriamente particolari certificati per installarlo sui loro dispositivi, oltre che debbono pagare l'apposita licenza. Google fornisce a tutti i dispositivi cerfiticati i servizi Google Mobile Services (in pratica GMail, Google Maps, Play Store e tutto il pacchetto Google).

Tutti i dispositivi prodotti, prima di esser legalmente approvati da Google per l'utilizzo del suo software, debbono passare il test di controllo obbligatorio: questo ha un costo sostenuto che si paga ogni tot numero di dispositivi testati, che solo i grandi produttori

possono permettersi.

Anche se il software è fornito liberamente, installare Android in un dispositivo non certificato e non testato è illegale, giacché Google trae guadagno proprio dalla vendita dei certificati e dai test.

Questo sistema di vendita, che i grandi produttori comunque possono sopportare e che anzi, costa di meno che avere un gruppo interno di progettazione dedicato, ha decretato il successo globale del Sistema.

Android 6.0 Marshmallow

Android presenta un'interfaccia grafica simil-iOS, basata su icone e tocchi gestuali.

È un Sistema multitasking sin dalla sua prima apparizione, e questo ne ha fatto sempre un punto di forza: il kernel derivato da Linux gli fa gestire le risorse hardware intelligentemente, rendendolo quindi adatto ad essere installato anche su dispositivi con hardware non brillantissimo.

Il Sistema è aggiornato da Google costantemente, anche in accordo con i principali partner produttori di hardware: tutte le versioni del Sistema hanno nomi di dolci o dolciumi vari (Kit-Kat, Lollipop, Marshmallow, ecc ecc.) e vengono rilasciate con cadenza irregolare, che comunque garantisce almeno 3-4 aggiornamenti l'anno (per numero di versione).

La caratteristica particolare della distribuzione di Android è che mentre Google

sviluppa e progetta il software, spetta ai produttori decidere se e come esso deve essere aggiornato, a seconda del modello del dispositivo.

Il più grande problema di Android è proprio nel suo più grande pregio: è un Sistema che può essere installato su una quantità enorme di dispositivi, e questo ne rende difficoltosa l'ottimizzazione.

D'altro canto, è un Sistema che rende bene anche su dispositivi con hardware non particolarmente potente, e perciò può essere distribuito nelle fasce basse del mercato (esempio: smartphone di settore cosidetto 'entry-level').

Android è compilato per processori ARM, sia a 32 bit che a 64 bit (dalla versione Lollipop in poi), e ne è stata sviluppata una versione anche per processori x86.

Complice il numero enorme di dispositivi prodotti da decine di marche differenti, Android detiene la più grande fetta del mercato smartphone globale: circa l'80% (al 2015).

iOS

iPhone iPhone commercializzato con la prima versione di iPhoneOS

Nel gennaio del 2006, Steve Jobs conferma mesi e mesi di indiscrezioni e presenta al mondo il primo telefono cellulare di Apple: iPhone.

Forse Jobs lo sa, od almeno sotto sotto lo spera vivamente: il mondo della telefonia globale sta

per cambiare totalmente da quella storica presentazione.

iPhone è il primo telefono mobile cellulare a far girare un Sistema proprietario derivato da UNIX; inizialmente conosciuto solo come iPhoneOS ed in seguito rinominato iOS, il Sistema mobile di Apple rompe qualsiasi tipo di schema precedente e ridefinisce pesantemente la telefonia mobile.

Il file manager del Sistema è ridotto all'osso: tutto passa per Springboard, ovvero

la 'scrivania' di iPhone, su cui sono presenti le applicazioni sotto forma di icone quadrate con gli angoli arrotondati.

Tutto il Sistema, specificatamente progettato per l'interazione tattile, è estremamente semplice da usare anche per i neofiti, e può essere governato e configurato in pratica con un solo pannello di controllo.

Il cambio concettuale nell'approccio ad un telefono mobile è considerevole: per la prima volta, la parte telefonica risulta accessoria, e moltissima importanza viene data ai contenuti quali Internet, mail, musica, foto e video.

Per i primi mesi di commercializzazione, Apple non permise agli sviluppatori di progettare direttamente le applicazioni per il suo nuovo Sistema, ma rilascò nel 2008 il primo SDK, unito alla prima versione dell'App Store (lo store digitale ufficiale) e la versione 2.0 del Sistema, in accompagnamento al nuovo dispositivo iPhone 3G, lanciato su scala globale.

Il successo fu planetario: in pochi mesi la mania dello 'smartphone' esplose in tutto il mondo, ed iniziò quella rivoluzione mobile, fino ad allora dormiente, che avrebbe poi profondamente cambiato sia il mercato della telefonia cellulare che dell'elettronica di consumo.

Innumerevoli le funzionalità e le innovazioni portate da iOS, copiate poi prontamente da tutti gli altri produttori software: tra le tante, vale almeno ricordare la facile installazione degli applicativi, lo store digitale, il posizionamento satellitare, la gestione comoda ed intutiva di musica, foto e video.

Con iOS 5.0, iOS integra per primo il servizio di cloud computing per tutti (parzialmente gratuito): iCloud, che diventerà una delle funzionalità di punta della Apple e verrà poi sistematicamente copiato da molte altre software house.

Inizialmente partito come Sistema monotasking (per i dubbi di Apple riguardo alla durata della batteria), da iOS 4.0 è divenuto multitasking, implementando pienamente anche la tecnologia push.

La GUI è cambiata nel corso degli anni: dapprima scheuomorfica e coerente con la caratterizzazione della controparte desktop (Aqua di OS X), da iOS 7.0 in poi ha subito un drastico cambio, diventando molto più lineare, semplificata e colorata, seguendo la moda del momento che vuole una rappresentazione 'flat' delle icone.

iOS 9.0 e la sua nuova interfaccia grafica

Fin dalla sua prima versione, l'integrazione col software iTunes è stata profonda, e si possono comperare musica, film, serie televisive e suonerie sia dall'app interna di iOS che dal software desktop.

Con l'introduzione del 3D Touch degli iPhone 6S e iPhone 6S Plus, iOS permette anche l'apertura di menù contestuali con l'opportuna pressione del digitalizzatore, emulando quindi la funzione storica del tasto destro del mouse.

Dalla versione 9.0 in poi, i documenti di iCloud possono essere letti direttamente dalla Springboard, semplificando così la navigazione.

In oltre 10 anni di sviluppo, iOS si è dimostrato un Sistema incredibilmente solido e sicuro, il cui kernel basato su UNIX ha permesso ad Apple di iniziare l'ennesima rivoluzione digitale, tornando finalmente la storica azienda innovatrice dopo anni di buio anonimato.

iOS gira su processori ARM a 32 e 64 bit, ed Apple mette mano personalmente all'hardware, progettando ogni volta una versione modificata della CPU ARM, e realizzando SoC (System-on-a-Chip) specifici: ne sono esempio gli A4, gli A5, gli A6, A7 e via discorrendo.

Nel 2010, col l'introduzione del primo iPad, iOS diventa il Sistema Operativo anche per la fortunata famiglia di tabelt di Cupertino, così come è il Sistema di gestione di Apple TV (dalla terza generazione in poi) e di iPod Touch.

Da iOS 6.0 in poi gli aggiornamenti del Sistema sono unificati per tutti i dispositivi: quando un aggiornamento è pronto, se aggiornabile, il dispositivo viene aggiornato a prescindere dal suo modello.

Problemi col tuo iPhone a Milano? Possiamo aiutarti?

Il nostro laboratorio è specializzato da anni nell'assistenza professionale a qualsiasi modello di iPhone.

Offriamo solamente servizio in loco in tutta Milano, non abbiamo una sede fisica: ciò ci permette di risparmiare sui costi e garantire prezzi e tempi d'intevento eccezionali!

Abbimo i migliori tecnici sul mercato, ed operariamo sempre con la massima qualità e professionalità, al prezzo più conveniente del mercato.

Se sperimenti problemi col tuo iPhone e necessiti di un rapido aiuto, puoi contattarci in qualsiasi momento: compila pure il modulo elettronico qui in basso, ed un nostro tecnico ti contatterà entro 24 ore.